ディープラーニングのCNNが何をやっているのか、そのメカニズム・仕組みについて独自解釈を書いてみました。

いや、単純・アタリ前の話だけどね。

◆前提

そもそも、画像認識のニューラルネットワーク(NN)は、何をやっているのかと言いますと。

画像(色の位置座標の集合)を複数の分類に変換している。

さらに、細かく書きますと・・・

画像(色の位置座標の集合)→複数の特徴とその位置→複数の特徴→複数の分類

と変換している。

最終出力の分類では、位置情報は消滅する。

分類を出すためには、分類を表現する特徴だけあれば良い。

早い話が位置情報はなくしたい。

が・・・話は簡単ではない。

画像認識では、特徴の関係が重要になる。

特に、特徴の位置関係が重要になる。

例えば、目と目の位置、目と口と鼻の位置関係、頭と体の位置関係など。

そのため、むやみやたらに位置情報を削除でない。

ゆっくりと、ゆっくりと位置情報を減らしていき、特徴情報を増やしていきたい。

◆CNN

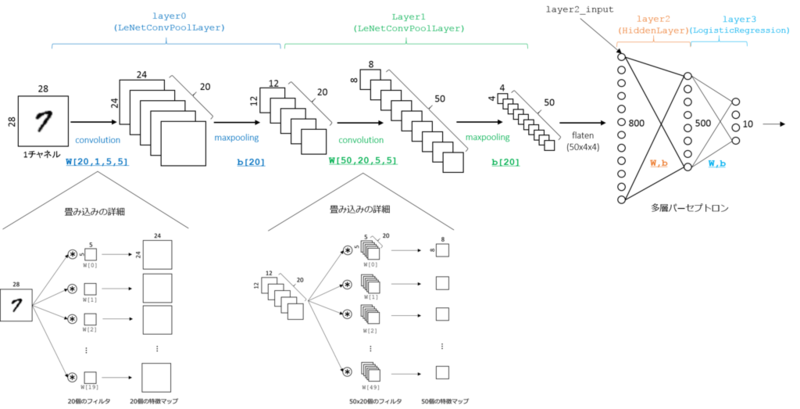

大変わかりやすい図がありましたので、引用させていただきます。

出典:人工知能に関する断創録 Theanoによる畳み込みニューラルネットワークの実装 (1)

http://aidiary.hatenablog.com/entry/20150626/1435329581

Layer0では、特徴マップ1枚大きさ(24×24)で特徴マップは20枚。

Layer1では、特徴マップ1枚大きさ(8×8)で特徴マップは50枚。

と、特徴マップの種類が増えている一方で

特徴マップ自身のサイズはどんどん小さくなっている。

ポイントは、特徴マップの種類が増えている点。

位置情報は、どんどん減っている一方で、特徴?の種類・情報はどんどん増えている。

ゆっくりと変換しているのだ。

そして、

Layer2では、特徴マップはなくなって普通のNNになっている。

(位置情報が完全にゼロになったわけじゃないけど)

以前、他のHPの説明を読んだ時、

畳み込み層(convolution layer)とプーリング層(pooling layer)の繰り返しが強調されていたんだけど、

特徴マップの種類が増えていることは、どうにも印象に残らなかった。

そのため私の中では理解の妨げになっていた。

必ずしも、特徴マップの種類を増やさなくても、機能するかもしれない。

でも、私としては、この点がポイントのような気がしてならない。