Scrapboxへ

前回の「最近Scrapboxを使っています」という投稿から約1年が経ちました。

その後、こちらはまったく更新されず、一方Scrapboxには続々と記事が投稿され、1000件を超えました。

そろそろきちんと「ここはもう更新されない場所で、今更新しているのはこちらのScrapboxだ」と明確化すべきかなと思います。

はてなダイアリーは僕が使ってきた色々な自己表現ツールの中で、最も長い期間使われたものでした。長らくありがとうございました。

最近Scrapboxを使っています

最近はScrapboxを主に使っています。

Scrapboxで作成日付をタグに入れて新規ページ作成する方法 - organize-ideas - Scrapbox

Scrapboxで文章オンリーのページを作った際に余白を有効活用する - organize-ideas - Scrapbox

前々からそろそろはてなダイアリーはobsoleteなのでどこへ移行しようかなと考えていたのですが、はてなブログ、Qiita、Mediumなどと比べて、Scrapboxは割とグッと来ています。

未踏会議と未踏ナイトの違い

未踏会議のデジタルサイネージがあちこちの駅で見られるようで、話題になっています。この機会に混同されやすい未踏会議と未踏ナイトについて改めて説明して置くことにします。

お〜い未踏、会議行こうぜ! (ナカジマ風) @HigeponJa pic.twitter.com/boguso0JVZ

— VIPPER (@tetsuokobayashi) 2017年2月25日

未踏会議は、完全招待制のイベントで、招待状がない人は参加できません。ニコ生で中継されるのでオンラインでなら誰でも見ることが出来ます。サテライト会場でパブリックビューイングという選択肢もあるようですが僕は参加したことがないのでわかりません。

IPAの公式ページ: https://www.ipa.go.jp/jinzai/mitou/2016/mitoukaigi2017.html

未踏ナイトは同日同会場で未踏会議終了後に行われる、未踏卒業生を中心とした交流イベントです。未踏関係者と未踏会議に招待された人が参加することが出来ます。

Facebookページ: https://www.facebook.com/events/1025361637607737/

申し込みページ: http://eventregist.com/e/vSvNCjdP4KS5

3Dプリンタで猫のエサ台を作った話

年末に友達の記事を読んで3Dプリンタのある生活はいいなと思ったので、3Dプリンタが家に来たら何を作るかなと考えて猫のエサ台を作ることにしました。3Dプリンタ自体を買うかどうかは「3Dプリンタで作ったものが家にある生活」をしばらくやってから考えようかと。

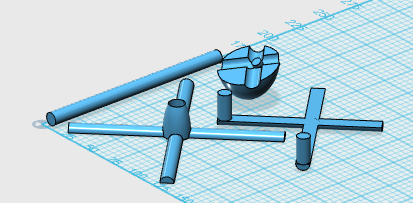

作るものはこれ。床に直接エサ皿を置くと低くて食べにくそうだったので適当な段ボール箱の上に置いてあるけどこぼしたご飯の油が染みたりして汚いです。これを3Dプリンタ出力で置き換えます。

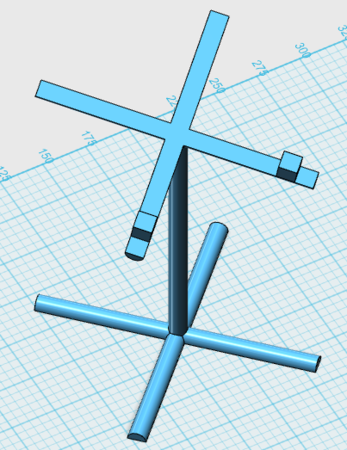

今の箱でもまだ低そうだったのでもう少し高くして、ついでに手前に15度ほど傾けました。エサ皿の下のくぼみに引っ掛けるための出っ張りを配置。

安定度がどうかは若干不安だったけど、ダメだったら直せばいいや、という気持ちで。ちなみにツールはAUTODESK 123Dで、無料です。作成にかかる時間的コストは30分程度。直方体や円柱のプリミティブを適当に並べて、ブーリアン演算で結合して、猫が触れうるところに角があるとよくないかな〜と思ってFilletで角を丸めただけ。

出力代行を発注してから3日くらいで届きました。見なれないのでしばらく下の棒の部分をクンクンしていたけど、納得して食べ始めました。特に不満は無いようです。もうちょっと高くしてもよかったかも。安定感は支障なし。

今回学んだこと

以前使ったDMM.make 3Dプリントを使ったのだけど、金銭的コストは意外と高いです。2万円くらい。でも5万円の3Dプリンタを買おうとしていたところだったので「買って使わなくて場所もとるしお金も無駄になるリスク」を考えたら2万でプロトタイププロジェクトを走らせるのはよいだろうという判断をしました。

元記事でPLAとかABSとかが話題になってましたけど、それに相当する選択肢がわからなかったのでナイロンを選択。これが後の話の伏線になります。

発注してから「3D Hubsとか使えばもっと安いんじゃないの」という指摘を受けて、試してみました。3D出力代行の一括見積みたいな感じ。こちらだと2000〜5000円ぐらい。せっかくなので同じものをプリントしてみて違いを比較してみようとします。

モデルを投稿すると出力代行業者の一覧が表示されます。いっぱい表示された!と思ったけどよく見たら日本なのは4件だけで、残りは海外でした。送料が書いてある通りの金額でよいのか疑問。一覧に表示された代行業者を選ぶと、チャット的な画面が表示されます。ここで代行業者と英語でコミュニケーションを取りながら発注を進めるわけです。面白いですね。

1つ目の代行業者からは「Design doesn't fit in my 3D Printer」というお断りのメッセージが30分ほどで届きました。理由は「It's difficult to model this object using our printer. For the special shape.」とのこと。「Please consider other modeling method and other hubs.」と言われたのでとりあえず他の業者に出してみることにしました。

2つ目の代行業者からは20分くらいで同じく「Design doesn't fit in my 3D Printer」との返事が。「I'm sorry. machine's vibration makes not collect printing and height of model is too high for my printer」とのことです。

3つ目の代行業者からは20時間くらいでお断りが。理由は「Due to Holiday season, we can process this order.」can'tって言いたかったんでしょうね。

「これがプリントできるサイズのプリンタ」で絞り込むことはできなかったので、試しに適当なプリンタを選択して絞り込んでみたり、いろいろ試行錯誤しました。ここら辺でボチボチわかってきたのですけど、彼らの3Dプリンタではサイズがフィットしない以前に、サポート材なしでこういう形状をプリントできないようです。モジャモジャになってしまう。Supports in 3D Printing: A technology overview | 3D Hubs DMM.makeで選んだナイロンは、たまたまサポート材がなくてもプリントできる素材だったようです。(粉末を固めるタイプなので粉末自体がサポートする仕組み) SLS Nylon 3D Printing | 3D Hubs

同じものを印刷してみてどういう差があるか比較しようと思っていたけど、同じものを印刷できないという結論になりました。

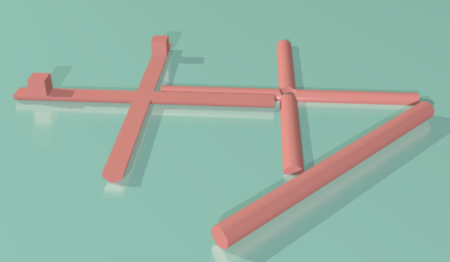

じゃあ分割しよう、ということで先ほどのモデルをブーリアンで3つのパーツに分割、2番目の代行業者の人に「これならプリントできるの?」って聞いたら「できるよ」との返事が。

だけどここで僕が日本から発注していることに気付いて「The price of overseas delivery is too much than this price of printing. are you sure this request?」とのこと。Too muchって言われてもどれくらいかわかんないじゃん。$30以下ならいいよ、と返事。

ここで先方からの返事が来なくなります。年末年始のお休みです。このころDMM.comからの出力が届きます。

休暇が開けて戻ってきた業者さんが「positional tolerance(0.25~0.5mm)がない」と指摘。ブーリアンで分けただけだから穴とそこに入れる棒のサイズが同じなんだけど、それじゃ刺さらないよ、とのことです。そうじゃないかとは思ってたけどいくら細くしたらいいかわからないからやすりで削ればいいかな〜なんて考えていました。親切〜。

あと業者さんが皿をホールドするためのcubesを外していいかと聞いてくるので、それは皿をホールドするためにつけてるのだけどなんで外したいの〜?とか質問したり。ワイワイしてます。モデルはどんどん複雑に…。

こういうやり取りが楽しめるなら3D Hubsを使うのもよいかと思います。DMM.makeを使う方が圧倒的に手間は無いけど、その分学びのチャンスも少ないかも。あとはTechshopとかに使いに行くのも試したいところですね。

(ここまで書いて、最初のモデルをSLS Nylonで出力した場合いくらになるのか気になったので確認してみたところ、一番近いのは中国の業者で96ドル、次がアメリカで140ドル+送料不明、3つ目が670AUDって感じでした。通貨そろえてほしい…。)

追記: 1/10 「I’ve updated the delivery on this order to EMS. "EMS delivery payment is only posible pay in advance . delivery weight :150g. korea cuurent :17900won->14.82 dollor."」とのことで、最終的に

- Startup Costs $3.00

- 17.6 ✕ 17.2 ✕ 3 cm $11.18

- Shipping $14.82

- Total $29.00

という金額になりました。

加工精度はこんな感じ。ハマらないよりはスキマが空いた方がマシ、という設計をしたので予想通りスキマが空いています。ダイソーで買った安物のホットボンドで接着しました。問題なさそうです。

こちらのリンクから$10のディスカウントが受けられるっぽいです: http://3dhubs.refr.cc/CVPNDJ5

猫ルアーフィッシング

猫ルアーフィッシングの動画を公開したら何というおもちゃか聞かれたので。

猫ルアーフィッシング pic.twitter.com/kk4u0Cu33K

— nishio hirokazu (@nishio) 2017年1月3日

Austrakeというやつです。

Da Birdというやつです。

うちの猫のウィッシュリストに替え羽を入れておいたけども、結構高いので羽素材を買って自作しようかなぁと考え中。

書評:夢見るプログラム

だいぶ前に著者の加藤博士から頂いていたもののいろいろ忙しくて紹介が遅れました。

この本は1999年に「人工無脳は考える」を立ち上げて「人と会話をするソフトウェア」(人工無脳)について研究・考察を続けてきた加藤真一さんによる本です。特に2章では21ページにわたって、Elizaに始まる人工無脳50年の歴史を俯瞰していてとても良いです。人工知能による会話フレームワークが鳴り物入りで紹介されたりしたときに、中身を見てルールベースだったりすると、僕とかは「ゅぃぼっと」かよ!とツッコみたくなるわけです。だけどゅぃぼっとは1996年だからもう20年も前なんですねぇ。

ルールベースの人工無脳が、育つにつれて「ルール追加の手間あたりの賢くなった実感」がどんどん0に近づいて、ルールの作り手のモチベーション維持ができなくなることは、その頃から既に知られていたように思います。機械学習の分野では同様に「教師データ追加の手間あたりの精度の向上」が指数的に減衰する問題が知られていて、それへの対処として能動学習(Active Learning)などのアプローチが生まれているわけです。そこら辺の知見を取り入れて昔より良くなったのかな〜と思ったら20年前と変わらないルールベースのフレームワークだったりすると「ゅぃぼっと」かよ!とツッコみたくもなるというものです。

3章4章では90ページほど使って、実際に基本のルールベース人工無脳を実装しながら解説していきます。冒頭の「舞台設定とキャラクタ設定を作る」は僕にはない発想で目から鱗でした。後半ではルールベースの人工無脳にありがちな「直前の発言だけに反応すると話題が続かない」への対処として文脈をマルコフ近似しようとするアプローチは面白かったです。