このタグの解説について

この解説文は、すでに終了したサービス「はてなキーワード」内で有志のユーザーが作成・編集した内容に基づいています。その正確性や網羅性をはてなが保証するものではありません。問題のある記述を発見した場合には、お問い合わせフォームよりご連絡ください。関連ブログ

ネットで話題

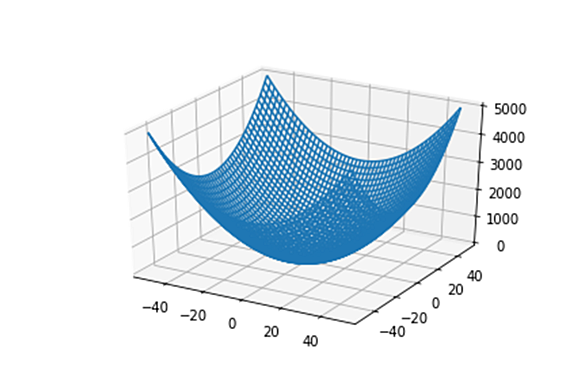

もっと見る29ブックマークprojects:sgd [leon.bottou.org]Learning algorithms based on Stochastic Gradient approximations are known for their poor performance on optimization tasks and their extremely good performance on machine learning tasks (Bottou and Bousquet, 2008). Despite these proven capabilities, there were lingering concerns about the difficu... leon.bottou.org

leon.bottou.org

13ブックマークYellowFin: An automatic tuner for momentum SGDYellowFin and the Art of Momentum Tuning by Jian Zhang, Ioannis Mitliagkas and Chris Ré. TLDR; Hand-tuned momentum SGD is competitive with state-of-the-art adaptive methods, like Adam. We introduce YellowFin, an automatic tuner for the hyperparameters of momentum SGD. YellowFin trains large ResNe... cs.stanford.edu

cs.stanford.edu