QWQ32B

このタグの解説について

この解説文は、すでに終了したサービス「はてなキーワード」内で有志のユーザーが作成・編集した内容に基づいています。その正確性や網羅性をはてなが保証するものではありません。問題のある記述を発見した場合には、お問い合わせフォームよりご連絡ください。関連ブログ

ネットで話題

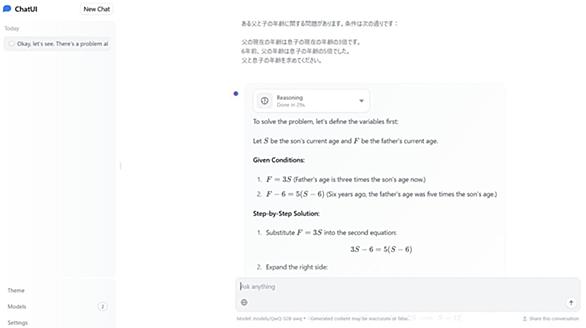

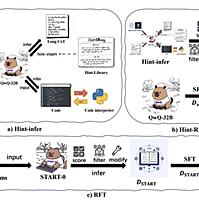

もっと見る21ブックマークQwQ-32B: Embracing the Power of Reinforcement LearningMarch 6, 2025 · 4 min · 742 words · Qwen Team | Translations:简体中文 QWEN CHAT Hugging Face ModelScope DEMO DISCORD Scaling Reinforcement Learning (RL) has the potential to enhance model performance beyond conventional pretraining and post-training methods. Recent studies have demonstrated that ... qwenlm.github.io

qwenlm.github.io