ブログの引っ越しを開始しました。

「はてなダイアリー」が廃止されるらしいので「はてなブログ」に引っ越します。とりあえず、「エーゲ海のある都市の物語」は神話と歴史の間のエーゲ海に再編します。

それにしても「はてなブログ」の使い方がよく分からない。

エーゲ海のある都市の物語:アイギナ(12):最終回。その後のアイギナ

前回の「(11):衰退」で、アイギナの話は終わりにしようと思っていたのですが、そうしたところどうも落ち着きがよくないと感じてきました。どこが変なのか考えてみたところ、現代もアイギナ(現代名エギナ)の町は立派に存在するのに、前回でまるでアイギナが滅亡したかのように書いて終わりにしたことが変なのだ、ということに思い当たりました。そこでその後のアイギナについても書こうと思ったのですが、これがなかなか難しそうです。

ペロポネソス戦争後、ローマ帝国の支配下にある時代までの歴史(私はそれ以降の歴史についてはあまり興味が持てないでいます)について英語版Wikipediaの「アイギナ」の項目の記述では、「アイギナと残りのギリシアは、マケドニア(BC 322〜299年)、アカイア同盟(BC 229〜211)、アイトリア同盟(BC 211〜210年)、ペルガモンのアッタロス(BC 210〜133年)、ローマ(BC 133 年以降)によって次々に支配された。」とあって、その次にはAD 1世紀に、コリントスのシナゴグの支配者で、のちにキリスト教徒になって使徒パウロから洗礼を受けたクリスプスによって、アイギナにキリスト教の共同体が設立された、という伝説の紹介に移っています。ここから察するにアイギナの町はローマ帝国支配下で存続していたのですが、大した歴史的事件の舞台にはならなかったようです。

一方、近代まで飛びますと、1821年からのギリシア独立戦争においてアイギナが「短い間、ギリシア革命当局の行政中心になった」という記事があります。また、ギリシア独立運動の中心人物である「イオニアス・カポディストリアス」の項には「1828年1月7日にカポディストリアスはナフプリオンに上陸し、1828年1月8日にアイギナ島に到着した。」という記述があります。ということは、この頃にはアイギナは重要都市に返り咲いていたことになります。

そこで、その間の歴史を書こうとするといろいろなことがあったらしく、私には書けそうもありません。たとえば、12世紀にはアイギナ島は海賊の根城になっていたそうです。なんという転変でしょう。

ところでヘロドトスは、アイギナの全住民追放という事件を、女神デメテルの神殿をアイギナ人が汚したのことの応報である、と説明しています。それはニコドロモスがアテナイと組んでアイギナ市内で反乱を試みた事件に関わる話です。

さてアイギナの資産家の一党はニコドロモスとともに彼らに反旗をひるがえした民衆の鎮圧に成功したが、鎮圧後反徒を市外に曳き出して処刑した。このことから彼らの身に穢れがかかることとなり、彼らはこの穢れを犠牲を供えることによって祓おうとしたがその甲斐なく、女神のご機嫌が直る前に島を追われる憂目に遭わなければならなかった。その経緯はこうである。――反乱を起した民衆の七百人を生捕りにして市外に曳き出し処刑したのであったが、その内の一人が縛めを解いて脱走し、デメテル・テスモポロスの神殿の入口のあたりに難を避け、扉の把手をしっかと握ってはなれなかった。追手の者たちは彼を引き離そうとしたがそれができぬと見ると、彼の両手を切り離しやっとのことで連れ去ったのであったが、切られた両の手は扉の把手に附いたまま離れなかった。

ヘロドトス著「歴史」巻6、91 から

- 作者: ヘロドトス,松平千秋

- 出版社/メーカー: 岩波書店

- 発売日: 1972/01/17

- メディア: 文庫

- 購入: 1人 クリック: 7回

- この商品を含むブログ (45件) を見る

しかし、これはあまりにも酷な見方ではないでしょうか? 貴族派がニコドロモスを中心とする民衆派を弾圧したやり方がむごかったとしても、そのためにアイギナの全住民が罰を受けなければならないというのは、道理に合わない話です。こういう話を読むと、アイギナのために何か弁じなければならない、という思いが湧きます。

アイギナはエーゲ海の東で始まった文明の発達を、エーゲ海の西側でいち早く吸収し、レラントス戦争をきっかけに、アテナイより先にエーゲ海の有力海上勢力として成長したのでした。そしてペルシアとの交易で盛期を迎えたものの、やがてペルシアとの全面戦争によって意に反してギリシア側の主力としてペルシアと戦うことになり、その功績第一とギリシア諸国に認められながらも、衰退せざるを得なかった町でした。そしてアテナイの隆盛の犠牲になってその栄光を失ったのでした。しかし、その後の長い歴史の中で町は復活し、現在も観光でにぎわう町として存続しているのでした。

以上で私のアイギナの物語を終えます。

エーゲ海のある都市の物語:アイギナ(11):衰退

サラミスの海戦ののち、アテナイはテミストクレスの主導により、さらに海軍力を高めていきスパルタとの間に緊張が走りますが、自分の功績を繰り返し誇示するテミストクレスがアテナイ民衆に嫌われ、陶片追放に会います。テミストクレスに代わってアテナイの主導権を得たのは穏健貴族派のキモンでした。キモンはスパルタとの協調政策をとり、そのおかげでスパルタと同盟関係にあるアイギナもアテナイと友好関係にありました。しかし、アイギナはサラミスののちフェニキアなどとの交易を失い、経済は低迷していました。サラミスの海戦ののち20年間平和は続きました。しかしBC 461年にキモンが陶片追放されると民衆派のペリクレスが政策を転換し、ペロポネソス半島のコリントスやエピダウロスなどと戦いを始めました。

アテーナイ人は船隊を率いてハリエイスにむかい、この地に上陸作成をおこない、コリントス、エピダウロス両国勢を相手に戦ったが、勝利はコリントス勢に上った。その後、ケクリュパレイア島沖合でペロポネーソス勢船隊と海戦をおこない、アテーナイ側が勝利を得た。

トゥキュディデス著「戦史」巻1、105 から

- 作者: トゥーキュディデース,久保正彰

- 出版社/メーカー: 岩波書店

- 発売日: 1966/02/16

- メディア: 文庫

- クリック: 26回

- この商品を含むブログ (28件) を見る

このケクリュパレイア島というのはアイギナのすぐそばにある小島でした。自分の目と鼻の先でアテナイ海軍が勝利を収めたのを見たアイギナはアテナイの勢力伸長を警戒し、他のペロポネソス諸国の艦隊を自国艦隊に組み入れてアテナイに戦いを挑みました。BC 459年のことです。

その後アテーナイとアイギーナの間にも戦争が生じ、アイギーナ島沖合で両国海軍の大海戦がおこなわれ、両側の同盟諸国軍もこれに参加した。アテーナイ側は勝ち、しかも敵船七十艘を捕獲すると、アイギーナ島に上陸して敵の城市を包囲攻撃しはじめた。アテーナイ側の指揮官は、ストロイボスの子レオークラテースであった。これをみてペロポネーソス同盟側はアイギーナ市民救援を目的に、先にコリントス・エピダウロス両国勢の配下にあった傭兵の重装兵三百をアイギーナ島に渡らせ、他方コリントス勢はゲラネイアの丘陵を占拠し、同盟諸軍を率いてメガラ領内に攻め降りた。かれらは、アテーナイが多数の兵力をアイギーナに送り、他方またエジプトにも進駐している現在、さらにメガラに援軍を繰出すことは出来ないだろう。若しアテーナイが援軍を出すとすれば、アイギーナの囲みを解いてその兵員を移動させねばなるまい、と考えたからである。しかしアテーナイ人はアイギーナ攻撃中の軍勢を移動させず、そのかわりに、本国に残っていた最年長と最年少の兵員を動員し、ミュローニデースの指揮下にメガラに駆けつけた。

トゥキュディデス著「戦史」巻1、105 から

アテナイ軍によるアイギナは包囲は3年も続きました。BC 456年、アイギナはアテナイに降伏することになりました。アイギナは自国の海軍を解体され、デロス同盟に加入しアテナイに年賦金を支払うことを強要されました。

アイギーナ市民もアテーナイ人の要求通りに降伏し、城壁を取壊し、船舶を譲渡し、爾後査定どおりの年賦金を支払うこととなった。

トゥキュディデス著「戦史」巻1、108 から

もはやアイギナはアテナイの従属国になってしまったのでした。BC 445年にアテナイとスパルタの間に30年の和約が締結されると、アテナイはアイギナの自治を復活させると約束しました。しかし実際には復活されませんでした。

その後、BC 432年、ペロポネソス側とアテナイの間に緊張が高まり、ポテイダイアというコリントスの植民市をアテナイが包囲するという事態になりました。この時、コリントスがペロポネソス同盟諸国にスパルタに集合して会議を持つように提唱したので、その会議にアイギナもひそかに使者を送りました。

しかしポテイダイアの籠城を本国のコリントス人は手をつかねて見ていたわけではない。かれらはかの都市の安否、そこに立籠ったコリントス市民たちの安否をいたく心配した。そこでただちに同盟諸国にラケダイモーンに集まるように呼びかけた。(中略)またアイギーナはアテーナイ人に遠慮して公けに代表を派遣しなかったけれども、ひそかに使を送って、アイギーナの自治権が和約に反して侵害されてることを述べ、アテーナイとの戦争をきわめて強硬に主張した。

トゥキュディデス著「戦史」巻1、67 から

このアイギナの強硬姿勢がアテナイ側に漏れたのでしょうか、いよいよアテナイとペロポネソス同盟が戦端を開くと(ペロポネソス戦争)、アテナイはアイギナの全住民を追放するという挙にでました。アイギナはアテナイに征服されてしまったのです。

同(=戦争一年目の)夏、アテーナイ人はアイギーナの市民、婦女子、子供ら一切に強制立退きを要求した。その理由は、今次大戦の主たる原因はアイギーナ人らの責任に帰せられる、というのであった。だがアテーナイ人としては、ペロポーネソスに近接するアイギーナの地理的条件にかんがみて、アテーナイ市民を入植させて管理させて置くほうがおり安全と思われたからである。じじつ程なくしてアイギーナにアテーナイ人植民団を入植させた。故国を追われたアイギーナ人を、ラケダイモーン人はテュレアに住まわせ、耕作を行うことを許した。これはアイギーナ人の反アテーナイ抗争と、かれらが震災と農奴反乱の際スパルタに与えた恩恵とをねぎらう意味の処置であった。テュレアの領土は、アルゴスとラコーニアとの緩衝地帯にあって、海岸にいたる斜面を占めていた。こうしてアイギーナ人の一部は此処に住みつくこととなり、他の者たちはギリシアのあちこちへと四散した。

トゥキュディデス著「戦史」巻2、27 から

しかし、テュレアに移住したアイギナ人も戦争中にアテナイ軍に襲われて、そのほとんどが殺害されるという悲運に見舞われます。ペロポネソス戦争の終わり頃、スパルタの将軍リュサンドロスがアイギナ人の残存者を集めて島に戻したのですが、もはやアイギナに昔の姿が戻ることはありませんでした。

エーゲ海のある都市の物語:アイギナ(10):サラミスの海戦

こうして始まったサラミスの海戦ですが、この海戦で一番活躍したのはアイギナの艦船でした。

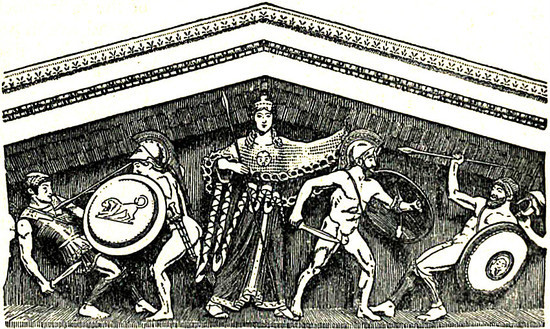

(左:サラミスの戦士の像)

さてサラミスのペルシア軍艦船の大部分は、アテナイ軍とアイギナ軍のために破壊され航行不能の状態に陥った。ギリシア軍が整然と戦列もみださず戦ったのに反し、ペルシア軍はすでに戦列もみだれ何一つ計画的に行動することができぬ状態であったから、この戦いの結果は、当然起るべくして起ったのである。ただしこの日のペルシア軍の働きは天晴れで実力以上の力を示したというべく、エウボイア沖の海戦当時と比較にならぬものがあった。ペルシア軍の将兵はいずれも大王の目が自分に注がれているものと思い大王を恐れるあまり大いに戦意を燃やしたのである。

ヘロドトス著「歴史」巻8、86 から

- 作者: ヘロドトス,松平千秋

- 出版社/メーカー: 岩波書店

- 発売日: 1972/02/16

- メディア: 文庫

- 購入: 2人 クリック: 10回

- この商品を含むブログ (21件) を見る

敗走したペルシア軍がパレロン目指して航行しているとき、これを海峡の出口に待ち構えたアイギナ部隊は、語るに足る見事な働きを示したのである。すなわちこの混乱の内にアテナイ部隊は抵抗する船と敗走する船を撃破したが、アイギナ部隊は海峡を脱出せんとする船の撃滅に当った。こうしてペルシアの艦船はようやくアテナイ軍の迫撃を逃れると、今度はアイギナ部隊の中へ直進する羽目に陥ったのである。

ヘロドトス著「歴史」巻8、91 から

この海戦でギリシア軍中最も名を揚げたのはアイギナ軍で、アテナイ軍がこれに続いた。個人ではアイギナ人ポリュクリトス、アナギュルス区のエウメネスおよびアルテミシアを追撃したパレネ区出身のアメイニアスの二人のアテナイ人であった。

ヘロドトス著「歴史」巻8、93 から

このように、ヘロドトスはアイギナ軍の働きが一番であったと述べています。

上の引用に登場する「アイギナ人ポリュクリトス」は、「(7):ペルシアからの服属要求 」に登場したクリオスの息子です。クリオスは、スパルタ王クレオメネスとレオテュキデスによって親ペルシア勢力の中心人物の一人として逮捕され、アテナイに送られて人質になったのでした。クリオスは「アイギナで最も勢力をふるっていた」とありますから、その息子のポリュクリトスもアイギナの最有力者の一人なのでしょう。

さて、このポリュクリトスは、以前のアルテミシオンの海戦の前哨戦で捕虜になったアイギナ人ピュテアスを、このサラミスの海戦でペルシア軍の一角を担うシドンの船から救出しています。シドンというのはフェニキアの町のひとつです。ピュテアスについては前回の「(9):進め、ヘラスの子らよ」に登場しました。

このシドンの船というのが他ならぬ、スキアトス島附近で哨戒中のアイギナ船を捕獲した船で、かのイスケノオスの子ピュテアスがこれに乗船していた。これはかつてペルシア軍がその武勇に感じ入り全身に手傷を負ったのを船内に保護した人物である。ペルシア兵とともにこのピュテアスを乗せていたシドンの船が捕獲され、かくてピュテアスは救われてアイギナへ帰国することができた。

ヘロドトス著「歴史」巻8、92 から

ここまでの記述から、アイギナは今までのアテナイに対する恨みを水に流して、共通の敵であるペルシアに向っているようにもみえます。しかし実はそうでもなかった、という記述もあります。上のポリュリトスがアテナイの司令官テミストクレスと海戦のさなかに出会った時の話です。

この時敵船を追っていたテミストクレスの船と、シドンの船に突撃したアイギナ人クリオスの子ポリュクリトスの船とが遭遇した。(中略)

さてポリュクリトスはアテナイの船に眼をとめ、司令官の標識を見てそれを知ると、アイギナがペルシアに与したという汚名を蒙ったことに関連して、大声でテミストクレスを非難し嘲罵した。

ヘロドトス著「歴史」巻8、92 から

ヘロドトスがポリュクリトスの言葉を記録していたら、もっといろいろなことが分かったと思うのですが、書かれているのはこれだけです。ポリュクリトスはアイギナの有力者で、海戦で大活躍しているのですから、アイギナ軍の司令官だったかもしれません(ヘロドトスはそうは書いていませんが)。そうするとこれはひょっとするとアイギナとアテナイの司令官同士の遭遇だったのかもしれません。そこでポリュクリトスが「テミストクレスを非難し嘲罵した」のですから、やはりアイギナはアテナイに強い恨みを含んだままなのでした。

それでもアイギナとアテナイが海戦中に仲違いすることはなく、ギリシア側はこの海戦で大勝し、その結果ペルシア王クセルクセスはあわてて本国に逃げ帰ったのでした。

海戦が終った後、ギリシア軍はなおその海域に漂流している破損した船体をサラミスに曳航し、新たな海戦に備えていた。彼らはペルシア王が残存の艦船を用いて攻撃してくることを予期していたのである。

ヘロドトス著「歴史」巻8、96 から

夜が明けて敵の陸上部隊がもとのままに留まっているのを見たギリシア軍は、水軍もパレロン附近にあるものと思い、敵が海戦を試みるであろうと信じて、抗戦の準備にかかっていた。しかし敵の水軍がすでに退却したことを知ると、ただちに追撃することに決した。彼らはアンドロス島まで迫ったが、クセルクセスの水軍の姿を認めることができなかった(後略)。

ヘロドトス著「歴史」巻8、108 から

翌年、ギリシアの海軍が集結したのはアイギナの地でした。そしてそれらの艦船がデロス島に進み、そしてイオニアのミュカレに上陸してペルシア軍を敗走させたのでした。

エーゲ海のある都市の物語:アイギナ(9):進め、ヘラスの子らよ

やがて2度目のペルシアの侵攻が始まりました。それは前回よりも大規模で、ペルシア王自らが軍を率いていました。テミストクレスは、対アイギナ戦のためにという名目で建造した200隻にのぼる軍船で、ペルシア軍に当ろうと考えます。

これより以前にも一度、テミストクレスが時宜にかなった説を唱えて、大勢を制したことがあった。それはラウレオンの鉱山からの収益である多額の金がアテナイの国庫を潤したので、市民一人当り十ドラクマずつ配当しようとした時のことである。この時テミストクレスはアテナイ人を説いてこの分配を中止させ、この金で戦争に備えて二百隻の船を建造させることに成功した。テミストクレスの意味した戦争というのは、対アイギナ戦のことだったのである。実際この戦争があったればこそアテナイは否応なく海軍国となったのであり、それによって今やギリシアが救われることになったのであった。もっともこれらの艦船は予定した目的には使用されなかったけれども、右に述べたような次第でギリシアにとっては正に絶好の機会に役立ったのである。

ヘロドトス著「歴史」巻7、144 から

- 作者: ヘロドトス,松平千秋

- 出版社/メーカー: 岩波書店

- 発売日: 1972/02/16

- メディア: 文庫

- 購入: 2人 クリック: 10回

- この商品を含むブログ (21件) を見る

上の引用で「もっともこれらの艦船は予定した目的には使用されなかったけれども」とあるのは、アイギナに対しては使用されなかったがペルシアに対しては使用されたという意味です。とはいうもののテミストクレスは元々ペルシアの再度のギリシア侵攻を予期していて最初からそのために軍船を作らせたともいいます。ペルシアの再度の侵攻の可能性を低く見ているアテナイ民衆に対して「対ペルシアのために」では説得が出来なかったので、最近のアイギナ戦での敗戦を引き合いに出して「対アイギナのために」という名目で民衆を説得したというのです。

さてペルシア軍はギリシアを北方から攻め、徐々に占領していきました。この状況を放置すべきではないと考えるギリシア人は多くの国の中にいました。

さてギリシア人の内、祖国の前途を憂い愛国の念に燃える者たちは一か所に会同し、互いに意見を交し盟約を誓い合ったが、協議の結果彼らにとって何を措いても果たすべき緊急事は、彼ら相互間の敵対関係や戦争を終結させ和解すべきであることに衆議が一決した。数ある相互間の紛争の中でも、特に重大であったのはアテナイ、アイギナ間の軋轢である。

ヘロドトス著「歴史」巻7、145 から

こうしてアイギナとアテナイの抗争は一旦停止され、両国は共同してペルシアに当たることになりました。しかし、この会議についてヘロドトスは個人の名前を挙げていないため、誰が重要人物で、どのような対立があり、どのように意見を集約していったのか、よく分かりません。たとえば、あとで登場するアイギナ人クリオスの子ポリュクリトスはアイギナの重要人物と推定されるので、この会議に参加した可能性もあると思うのですが、彼についての記述がなく残念です。また、なぜアイギナが今までの親ペルシア政策を放棄したのか、その理由もよく分かりません。この時になってギリシアの民族意識が高まったのでしょうか? それも一つの可能性として考えられます。民族意識というのは時に、想像を超えて高揚するという事実が、歴史の中でしばしば見受けられるからです。しかし、私にはこの時のアイギナの政策転換がそうであったとは断言出来ません。

さて、ペルシア勢とギリシア勢との最初の決戦は、陸上ではテルモピュライ、海上ではアルテミシオンという、近接した場所で行われました。テルモピュライの戦いというのは、映画「300」で有名な、スパルタ軍が少人数でペルシアの大軍に善戦し、全員戦死した戦いです。これについてはアイギナとは関係が薄いのでこれ以上は述べません。ここでは、アルテミシオンの海戦の起こる前の話を紹介します。ギリシア側はペルシア海軍がどこにいるかを探るために、トロイゼン、アイギナ、アテナイの船をそれぞれ一隻ずつ派遣して、探索に当らせていました。

クセルクセスの水軍はテルメの町を発進すると、まず最も快速を誇る十席の船をもってスキアトスに直行した。ここにはギリシア船三隻――トロイゼン、アイギナおよびアテナイの船それぞれ一隻――が前線で警戒に当たっていたのであるが、ペルシアの艦艇の姿を認めると遁走をはかった。

ヘロドトス著「歴史」巻7、179 から

このうち、トロイゼンの船はたちまち捕獲され、乗員は殺されてしまいました。アテナイの船はからくも逃げ切ることが出来ました。アイギナの船はといいますと、ペルシア海軍に向って奮戦したのでした。

アソニスなるものが指揮していたアイギナの三段橈船には、ペルシア方も少なからず手を焼いた。この船に乗り組んでいたイスケノオスの子ピュテアスの働きによるもので、この男は当日の戦闘に最も目覚ましい武功をたてたのであった。船が捕獲されても彼は戦い続け、全身ズタズタに切り裂かれるまで戦いを止めなかった。倒れてもなお死に切らず息のあった彼を、その勇武に感じ入った乗組のペルシア兵たちは、何とかしてその生命を救いたいと、傷に没薬を施し上質の亜麻の繃帯を巻いて手当をしてやった。ペルシア軍は自軍の陣営に戻ると、全軍の兵士に彼の姿を示して賞めちぎり、厚く遇したが、同じ船で捕えた他の兵士たちは、これを奴隷として取り扱ったのであった。

ヘロドトス著「歴史」巻7、181 から

この記述から、政策転換後のアイギナの戦意が高かったことが分かります。

その後、アルテミシオン近辺で海戦が何回か繰り返されましたが、勝敗は決しませんでした。しかし同時に行われていたテルモピュライの合戦で、スパルタ軍が玉砕したことがギリシア艦隊へ伝えられると、ギリシア艦隊は撤退しました。テルモピュライが突破されては、海上でいかに頑張ろうとペルシア陸軍は陸伝いにアテナイまで進んでしまうからです。スパルタを中心とするペロポネソス諸国はコリントス地峡に防壁を築いて戦うことにしました。これはアテナイやアイギナを見捨てて、ペロポネソス半島だけを防衛する策でした。これはアテナイやアイギナの容認出来ることではありません。アテナイの艦船は、他のギリシア海軍にはサラミス島に集結するように要請したうえでアテナイに帰国し、住民をアテナイから別のところへ避難するよう布告を発しました。大多数の者はトロイゼンに避難しましたが、アイギナ島やサラミス島に向った者もいました。

サラミスに終結したギリシア艦隊の中には、やはりコリントス地峡に撤退しようと言い出す者もいましたが、全体の指揮官であったスパルタ人エウリュビアデスはテミストクレスに説得され、最終的にはここで戦うことに決定しました。

サラミスのギリシア人の間にはこのような言葉の小競合いがあったが、エウリュビアデスが右の方針を決定すると、その場で海戦の準備にかかった。夜が明け陽が昇ると同時に、陸上にも海中にも地震が起った。ギリシア軍は神々に祈願し、アイアコス一族(の霊)の救援を請うことに決した。そして決定すると同時にこれを実行したのである。よろずの神々に祈願した後、サラミスからはアイアスおよびテラモン(の神霊)の加護を請い、アイギナへはアイアコスおよび他のアイアコス一族を勧請のため船を送った。

ヘロドトス著「歴史」巻8、64 から

ここで「アイアコス一族」の助力を祈っています。「アイアコス一族」はこれほどまでに頼りにされていたのでした。特に戦いの舞台となるサラミス島を領有したのがアイアコスの子テラモンと、その子アイアスでした。

しかしここで指揮官たちの意見の対立が再燃しました。それでも、自分たちが夜中のうちにすでにペルシア艦隊によって包囲されているという知らせをアテナイ人アリステイデスから受けると、この対立は解消しました。もはやここで戦うしか道が残されていなかったのです。

かくてギリシア軍が乗船にかかったころ、アイアコス一族の神霊を迎えに行っていた三段橈船が、アイギナから帰ってきた。ここにおいてギリシア軍は全艦船をもって外海に乗り出したが、それと同時にペルシア軍はただちに彼らに迫ってきた。

(中略)

アイギナ人の説では、アイアコス一族の神霊を迎えにアイギナに使いした船が戦端を開いたのだという。また次のようなことも伝わっている。ひとりの女の姿がギリシア軍の眼前に現われ、まず

「腑甲斐ないものどもじゃ、そなたらはいつまで逆櫓を漕ぐつもりじゃ。」

と罵った後、ギリシア全軍に聞えるほどの大声で鼓舞激励したという。

ヘロドトス著「歴史」巻8、83・84 から

ここでこの「ひとりの女の姿」というのは何か神的な存在なのでしょう。その存在が何という言葉で「ギリシア全軍に聞えるほどの大声で鼓舞激励した」のか残念ながらヘロドトスは記していません。私は、アイスキュロスのギリシア悲劇「ペルシアの人々」の中に出てくる次の言葉だったら状況にピッタリだなと想像しています。

進め、ヘラスの子らよ!

祖国に自由を!

エーゲ海のある都市の物語:アイギナ(8):勝利

アテナイは有名なマラトンの戦いでペルシア軍に大勝します。ペルシアの脅威を除去したアテナイは、親ペルシアのアイギナの現政権を転覆させ、親アテナイの政権を樹立しようとする陰謀を進めました。アテナイ側が目を付けたのは、アイギナで貴族政に反対するアイギナの民衆派の指導者ニコドロモスでした。この頃アテナイは民主政を施行してかなり年月が経っていました。そのこともあってアイギナの民衆派は親アテナイ反ペルシアでした。

以下のヘロドトスの記述にはアテナイ側の偏見が入っているような気がします。ヘロドトスはアテナイに長く住んでいたので、アテナイ人のアイギナへの敵意がヘロドトスの記述に反映されるということもあったと思うのです。

さてここにクノイトスの子ニコドロモスというアイギナでは名の通った人物がいたが、この男は以前自分がアイギナ島から追放されたことから、アイギナ人を快く思っておらず、そこでこの時アテナイ人がアイギナを侵害しようとしているのを聞くと、祖国を裏切ってアイギナをアテナイ人の手に委ねる協定を結び、自分が蹶起する日を告げ、その日に彼らも救援に駆け参ずべきことを伝えたのである。その後ニコドロモスはアテナイ人と打ち合わせたとおりにいわゆるアイギナの旧市街を占拠したが、アテナイ人の来援は間に合わなかった。

ヘロドトス著「歴史」巻6、88 から

- 作者: ヘロドトス,松平千秋

- 出版社/メーカー: 岩波書店

- 発売日: 1972/01/17

- メディア: 文庫

- 購入: 1人 クリック: 7回

- この商品を含むブログ (45件) を見る

ニコドロモスはおそらく上の記述で描かれるような祖国への裏切り者という面では捕えきれないものがあったと私は想像します。さて、なぜアテナイ側がニコドロモスの蹶起に間に合わなかったかといいますと、アイギナに対抗できるだけの軍船を準備することが出来なかったからです。そのためニコドロモスの反乱は失敗しました。

その理由はアイギナの艦隊と交戦できる戦闘力を持った艦船がアテナイに不足していたからで、彼らがコリントスに艦船の貸与を乞うている間に、陰謀は挫折してしまったのである。(中略)アテナイ人はこれらの船を入手するとこれに自国の船も加え総数七十隻を装備してアイギナに向い、約定の日より一日遅れて到着した。

ニコドロモスはアテナイ軍の来援が間に合わぬのを知ると、船に乗ってアイギナから逃走した。ニコドロモスには他のアイギナ人も同行したが、アテナイ人は彼らがスニオンに居住することを許した。そこで彼らはここを根拠地として、アイギナ島の住民を襲い掠奪を繰返したのであった。

ヘロドトス著「歴史」巻6、89・90 から

アイギナは民衆派の反乱を鎮圧し、来攻したアテナイ船団を迎え撃ちました。アテナイ船団も七十隻でしたが対するアイギナの船団も七十隻でした。そして一旦はアテナイに敗れたのでしたが、その後、アルゴスからの義勇兵の助力を得て、再度アテナイ船団に戦いを挑み、これに大勝したのでした。

さてアイギナはその戦隊をもって、戦列の整わないアテナイ軍に襲いかかってこれを破り、四隻の船を乗員ぐるみ捕獲した。

ヘロドトス著「歴史」巻6、93 から

この時から第二次ペルシア戦争までの期間、BC 490年から480年までの10年間がアイギナの最盛期でした。アイギナの最盛期については調べてもなかなか具体的な記事が見つからないのですが、英語版のWikipediaにはこの頃のアイギナの彫刻家の名前が出ていました。スミリスはBC 6世紀のアイギナ生まれの彫刻家で、この最盛期より前に活躍したようです。彼はサモス島のヘラ神殿のヘラ神像を作ったとのことです。オナタスとプトリコスはアイギナの最盛期に活躍したアイギナ生まれの彫刻家です。英語版のWikipediaのオナタスの項の記述によれば、オナタスはアフェア神殿のペディメント(=破風)の彫刻を作ったようです。そのWikipediaの記述では、オナタスが作った彫像の特徴を「それらは男っぽく、丈夫で、運動神経がよさそうで、人間の姿についての偉大な知識を示しているが、どこか堅苦しく自動人形に似ている。They are manly, vigorous, athletic, showing great knowledge of the human form, but somewhat stiff and automaton-like.」と述べています。

アテナイの有名なパルテノン神殿の彫像に比べてこれらの彫像が優美さに欠けるように感じられるとしたら、それはオナタスの技量によるよりも、パルテノン神殿に比べてこのアフェア神殿が約50年先行するという事実が大きいのではないか、と私は思います。アフェア神殿が建設されたBC 500年頃はまだアルカイック・スマイルが一般的な時代でした。もっと自然な表現が可能になるためには技術の進歩が必要なのでした。

ところでこの海戦はアテナイに深刻な危機感を与えました。この頃アテナイの民衆派のリーダーとして頭角を現しつつあったテミストクレスは、アイギナに勝つために軍船を大量に建造することをアテナイの民会に提案しました。

テミストクレスが時宜にかなった説を唱えて、大勢を制したことがあった。それはラウレオンの鉱山からの収益である多額の金がアテナイの国庫を潤したので、市民一人当り十ドラクマずつ配当しようとした時のことである。この時テミストクレスはアテナイ人を説いてこの分配を中止させ、この金で戦争に備えて二百隻の船を建造させることに成功した。テミストクレスの意味した戦争というのは、対アイギナ戦のことだったのである。実際この戦争があったればこそアテナイは否応なく海軍国となったのであり(後略)

ヘロドトス著「歴史」巻7、144 から

- 作者: ヘロドトス,松平千秋

- 出版社/メーカー: 岩波書店

- 発売日: 1972/02/16

- メディア: 文庫

- 購入: 2人 クリック: 10回

- この商品を含むブログ (21件) を見る

つまりアテナイは、この敗戦がなければ海軍国として覇を唱えることもなかったのでした。アイギナの最盛期は、その裏に没落の要因を成長させていたのでした。

エーゲ海のある都市の物語:アイギナ(7):ペルシアからの服属要求

BC 498年、ミレトスを中心とするエーゲ海東側のギリシア諸都市がペルシアに対して反乱を起こしました(イオニアの反乱)。エーゲ海の西側では、アテナイとエウボイア島のエレトリアがこの反乱に援軍を派遣しました。イオニアの反乱は最終的にはBC 494年にペルシアによって鎮圧されたのですが、この反乱にアテナイとエレトリアが援軍を出したことがペルシア王ダレイオスに、ギリシア本土進攻の口実を与えたのでした。

ダレイオスは、ギリシア人が果して自分に対して戦う意志があるのか、それとも結局は屈伏しようというのかどうかを試みようとして、ペルシア王に土と水を献ぜよと要求する使者をギリシア各地に派遣した。

ヘロドトス著「歴史」巻6、48 から

- 作者: ヘロドトス,松平千秋

- 出版社/メーカー: 岩波書店

- 発売日: 1972/01/17

- メディア: 文庫

- 購入: 1人 クリック: 7回

- この商品を含むブログ (45件) を見る

この「土と水を献ずる」というのは、ペルシア王に服属する意思を示す、という意味でした。

ギリシアに派遣された使者に対し、本土においてもペルシア王の要求どおり土と水を献じた町は少なくなかったが、島嶼に至っては使者の訪れたことごとくの島がその要求を容れたのである。

ヘロドトス著「歴史」巻6、49 から

ペルシアは大国であり、戦っても勝ち目はないだろうと思うエーゲ海の島々の住民は多かったのでした。それにイオニアの反乱の鎮圧後であってもイオニアにおけるペルシアの支配はそれほど厳しくはなかったこともうわさで知っていただろうと思います。そうなると下手に反抗するよりも早めに服属の意をペルシア王に示したほうが得策だと考えたとしても、あながち非難できるものではありません。

ところがダレイオスに土と水を献じた多数の島の中には、アイギナも加わっていた。

この頃アイギナの貿易相手はペルシアの支配下の町々が多かったのでした。ペルシアからの服属要求を拒否すれば、自国の経済が崩壊してしまいます。それにペルシアが敵視しているのはギリシアの中でも、この時点ではアテナイとエレトリアの2市だけなのです。ここはペルシアの要求を呑むしかありません。しかし、それに異を唱えたのが隣国のアテナイでした。

アイギナがこの挙に出ると間髪を入れずアテナイはアイギナ攻撃の火蓋を切った。アテナイとしてはアイギナがペルシア王に屈服した真の狙いはアテナイであり、アイギナはペルシア王と組んでアテナイを攻める意図であると考えたからで、好い口実を得たことを喜び、スパルタと連絡をとりアイギナ人の行動はギリシアを裏切ったものであるとしてその罪をスパルタ人に訴えたのである。

ヘロドトス著「歴史」巻6、49 から

アテナイがなぜこのことをスパルタに訴えたのか、よく分かりません。アイギナがドーリス人の国であることから、ドーリス人の中心的な国としてのスパルタに裁決を委ねたのかもしれません。

ところでスパルタには2つの王家があり、常時2人の王がいました。この2人の仲が良ければ問題ないのですが、この時は仲が非常に悪かったのでした。この時1人の王(クレオメネス)はアイギナを罰しようとしたのですが、もう1人(デマラトス)はそれに反対しました。

当時スパルタの王はアレクサンドリデスの子クレオメネスであったが、右のアテナイの訴えをきくとアイギナの首謀者をとらえようと考えてアイギナへ赴いた。しかし彼が首謀者の逮捕に奔走している時、彼の措置に反抗したアイギナ人も少なくなかったが、中でもポリュクリトスの子クリオス(「牡羊」の意あり)が最も強硬で、クレオメネスがアイギナ市民を一人たりとも連行しようとするならば、ただでは済まさぬと公言した。クレオメネスの今度の行動は、アテナイ人に買収された結果であって、スパルタ国民の総意によるものではない、さもなくば彼は当然もう一人の王と同行して逮捕にきたはずだというのである。クリオスがこのような発言をしたのは、デマラトス(=もう一人のスパルタ王)の入れ知恵によるものであった。

クレオメネスはアイギナを退散するにあたって、クリオスにその名を訊ねた。クリオスが名乗ると、クレオメネスは彼に向っていうのは、

「牡羊よ、今からもうその角を青銅張りにしておくがよいぞ。やがて大変な目に遭うことになろうからな。」

ヘロドトス著「歴史」巻6、50 から

クレオメネスは陰謀をめぐらしてデマラトスを追放し、その代わりにレオテュキデスを王を立てました。そしてレオテュキデスと共に再びアイギナにやってきました。前回の時にクレオメネスに抵抗したクリオスは、今回は拘束されてしまいます。以下の文からクリオスがアイギナの有力貴族の出であることが分かります。これらの有力貴族が親ペルシア派だったわけです。

クレオメネスのデマラトスに対する工作が思いどおりに運んだ後、クレオメネンスはただちにレオテュキデスを帯同してアイギナに向った。彼は先に加えられた侮辱の故に、アイギナ人に対しては激しい怨恨を抱いていたのである。かくしてアイギナ側も、二人の王が打揃って出向いたからには、これ以上逆らうのはよろしくないと考え、市民の内から資産も家柄も共にぬきんでた者十人――中でもアイギナで最も勢力をふるっていたポリュクリトスの子クリオス、アリストクラテスの子アサンボスの二名を含み――を選んでスパルタ側に引き渡した。クレオメネスは彼らをアッティカ領内に連行し、アイギナ人には不倶戴天の敵なるアテナイ人にその身柄を預けたのであった。

ヘロドトス著「歴史」巻6、73 から

その後、しばらくしてクレオメネスは死亡してしまいます。アイギナはスパルタ政府に対して、王たちの行為が不法なものであったと訴えました。スパルタではその王権は弱く、民会によって王が罰せられることもしばしばありました。

アイギナ側ではクレオメネスの死の報に接すると、アテナイに人質として監禁されている者たちに関し、レオテュキデスの罪を糾弾するために使節をスパルタへ送った。スパルタでは法廷を開いて審議した結果、レオテュキデスがアイギナ人に対してとった措置は不法であることを認め、アテナイに監禁されている者たちの身代りとして、レオテュキデスを引き渡し、アイギナへ連行させるという判決を下した。

さていよいよアイギナ人がレオテュキデスを連行しようとしているとき、レオプレペスの子テアシデスというスパルタでは名のある男が彼らに向っていうには、

「アイギナの方々よ、そなたは何をしようとなされるのか。スパルタ人が引き渡したからスパルタ王を連行してゆくというわけか。スパルタ人は今は(レオテュキデスに対して)憤激したあまりこのような決定を下したのであるが、そなたらがかようなことをなさるならば、やがて後になってスパルタが、貴国にとってとり返しのつかぬような面倒を貴国に持ち込むかも知れぬことを用心なされるがよい。」

アイギナ人たちはこの言葉をきいてレオテュキデスを連行することは断念し、話し合いの結果レオテュキデスが彼らとともにアテナイへ赴き、監禁されている者たちをアイギナ側へ返すという協定を結んだ。

レオテュキデスがアテナイに着いて、預けておいたアイギナ人たちの返還を求めたところ、アテナイ側では返還を望まずさまざまな口実を設けたがその言い分というのは、人質は二人の王から預かったのであるのに、今一人だけに返還するというのは理屈に合わぬ、というのである。

ヘロドトス著「歴史」巻6、85・86 から

結局スパルタ王レオテュキデスは、人質返還の交渉に失敗したままスパルタに引き上げました。この人質たちがアイギナに帰国出来たのがいつなのかヘロドトスは記していません。私は、その後数年で帰国したのではないかと推測しています。アイギナは次の行動をとったからです。

(アイギナ人は)スニオンでアテナイ人が五年目ごとに祝う祭のあった折、待伏せをしてアテナイの一流の知名人を満載した祭礼使(テオーロス)の船を捕獲し、乗船の人々を捕えて投獄したのである。

ヘロドトス著「歴史」巻6、87 から

アイギナはこの捕えた人々と、アテナイに囚われている自国の人々の交換に持ち込んだのではないか、というのが私の推測です。