エントロピー

(サイエンス)

【えんとろぴー】

【entropy】無秩序さや乱雑さの度合い。

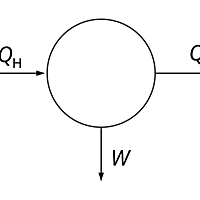

- 熱力学的には、可逆な過程で系に与えられた熱量を系の絶対温度で除したものが過程の前後のエントロピーの差と定義される。

- 統計力学的には、系が取りうる状態の数の自然対数にボルツマン定数をかけた量。

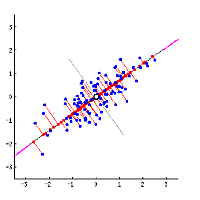

- 情報科学的には平均情報量と同義。情報量の期待値。単位はビットになる。

情報科学におけるエントロピー

情報量の計算では、確率 P で起こる事象に関する情報量はビットと計算される。確率 1/8 で起こることなら 3bit、など。稀な事象が起こったという情報ほど情報としての重要性が大きいと言うこと。たとえば「今日は中央線が人身事故のため遅れています」という情報はよくあることなので情報量が低い。しかし「阪神が日本シリーズで優勝した」という情報は稀なことなので情報量が多い。

なぜ なのかというと、例えば「中央線が止まってて、阪神が日本シリーズで優勝した」という情報の情報量はそれぞれの情報量の和になるが、そういう事が起こる確率はこの場合二つの事象がほぼ独立と考えられるので、中央線が止まる確率

と阪神優勝の確率

の積

となる。

となるので、log ならばちゃんと二つの情報量の和になることが分かる。

- エントロピー

- 結合エントロピー

- 条件付きエントロピー

- 相互情報量

- 不確定性係数